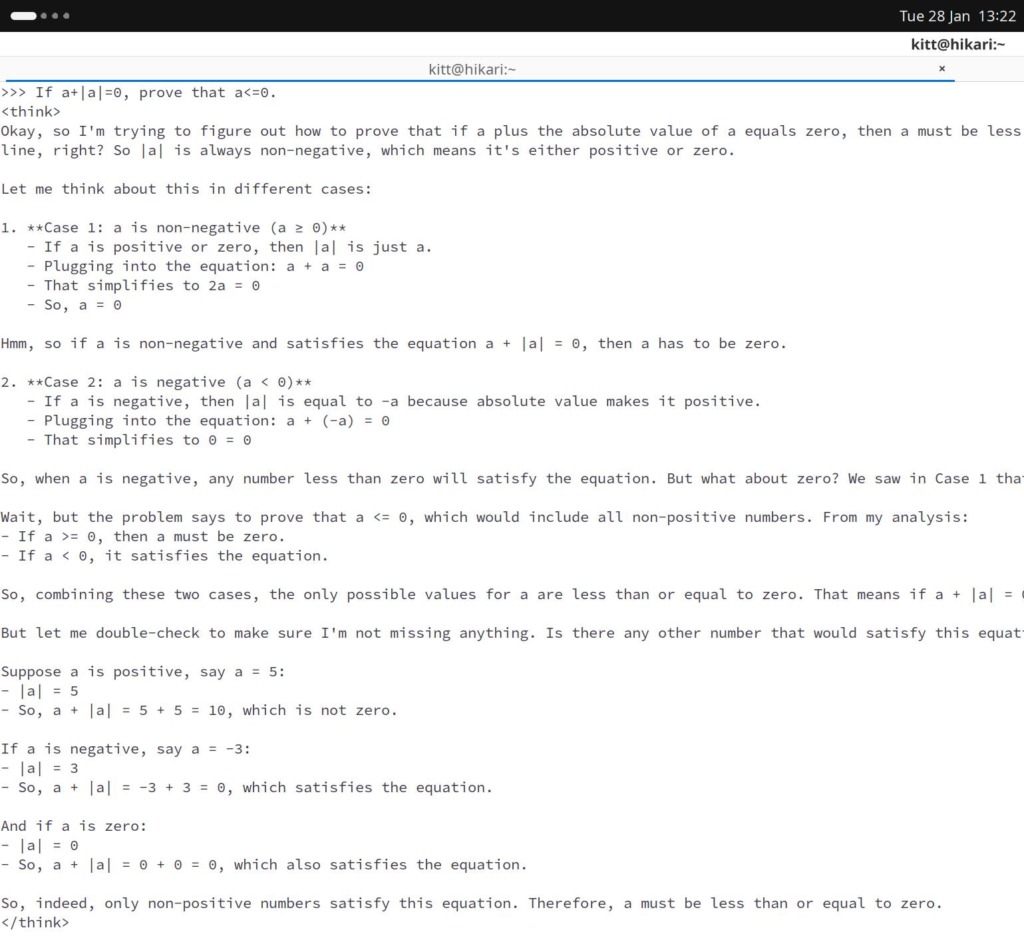

ลองเอา deepseek-r1:1.5b ตัวเล็กสุด มารันใน notebook ตัวเอง

มันเก่งจริงอย่างที่หลายคนอวยยศแฮะ response เร็ว กิน resource น้อย (อจก. ตามไปอ่าน architecture ของ deepseek แล้ว ในทางวิศวกรรม #ของแทร่ อยู่เด้อ)

ประเด็นคือออ .. model ขนาด 1-2b parameters หลาย ๆ models นี่ คอมพิวเตอร์ทั่ว ๆ ไป มี memory เหลือสัก 1.5-2 GB ก็รันได้แล้วนะครับ ไม่ต้องมี GPU/NPU ช่วย accelerate ก็รันได้ (เครื่อง อจก. ก็ไม่มี GPU/NPU)

ยิ่งถ้ามี AI-accelerated (e.g., CPU+NPU, Copilot+ PC) ที่กำลังทยอยออกมาวางขายผู้ใช้งานทั่วไป การรัน model เล็ก ๆ แบบนี้จะได้ response เร็วขึ้น ประหยัดพลังงาน และมีรายละเอียดมากขึ้นได้ (i.e., input/output tokens เยอะ ๆ ไม่ต้องกลัวเปลืองตัง)

.. ถ้าห่วงเรื่องข้อมูลส่วนตัว หรือกลัว footprints ปรากฏ online ก็จะมีทางเลือกทำ chat/RAG/agent บน device ของตัวเองเป็น offline ได้เลย