อ้า..ช่วงนี้เห็นหลายคนสอบ midterm กันใหญ่ เป็นยังไงกันบ้างหนอ ส่วนผมปิดเทอมแล้ว ก็เลยว่างมาเขียนบทความซะที ช้าไปหน่อยแต่ก็ยังมีให้อ่านล่ะนะ แหะๆๆ วันนี้เป็นเรื่อง backbone ของ เครือข่ายอินเทอร์เน็ต .. backbone เป็นเครือข่ายที่อยู่ยอดสูงสุดในการส่งข้อมูลผ่านเครือข่ายอินเทอร์เน็ตและ เป็นเครือข่ายที่เชื่อมอินเทอร์เน็ตของแต่ละประเทศเข้าด้วยกัน .. อืมมม ฟังดูใหญ่โตจัง ในตอนท้ายจะมีข้อมูลของลักษณะ traffic ใน backbone มาให้ดูกันด้วย .. มาเริ่มกันเลยดีกว่า

Backbone ในอดีต: National Science Foundation Network

Backbone ของอินเทอร์เน็ตอาจจะพอกล่าวได้ว่าเริ่มต้นมาจากเครือข่าย NSFNET … เนื่องจากในปี 1987 รัฐบาลสหรัฐเริ่มเห็นแนวโน้มว่าการสื่อสารข้อมูลมีความสำคัญมากขึ้น National Science Foundation ก็เลยสร้างเครือข่ายที่เรียกว่า NSFNET – National Science Foundation Network เพื่อเชื่อมต่อ supercomputer sites 6 แห่งเข้าด้วยกัน ได้แก่

- The San Diego Supercomputer Center (SDSC)

- National Center for Atmospheric Research (NCAR)

- National Center for Supercomputing Applications (NCSA)

- Cornell National Supercomputing Facility (CNSF)

- Pittsburgh Supercomputing Center (PSC)

- Jon Von Neumann Center (JVNC)

เครือข่าย NSFNET ทำให้ระบบเครือข่ายแบ่งออกเป็น 3 ชั้น (3-level hierarchy) ชั้นบนสุดเป็น backbone ที่เชื่อมเครือข่ายย่อยทั้งหมดไว้ด้วยกัน คลุมพื้นที่ทั้งประเทศว่างั้นเถอะ ชั้นกลางเป็นระดับ regional network ครอบคลุมระดับ local site ทั้ง site ประมาณว่าเป็น backbone ของ site นั้นๆ ส่วนชั้นล่างสุดเป็นเครือข่ายภายในระดับ campus/access level ซึ่งกระจายจุดเชื่อมต่อให้ computer/terminal NSFNET ทำให้นักวิจัยสามารถใช้งาน supercomputer ทั้ง 6 แห่งในการคำนวณทางวิทยาศาสตร์และวิศวกรรมได้อย่างสะดวก…

NSFNET เชื่อมต่อระหว่าง site ใน level บนสุดโดยใช้ 56 Kbps leased line (ยืมวิธีการมาจาก ARPANET ซึ่งใช้มาตั้งแต่ปี 1968 สมัยนั้นก็ถือว่าเร็วมาก modem 300 bps ยังแพงสุดๆ) ส่วน access level ใช้ Ethernet 10 Mbps protocol ที่ใช้ก็คือ TCP/IP เหมือนกับ ARPANET และเหมือนกับ Internet ในปัจจุบัน หลังจากสร้างเครือข่ายได้ไม่นานในปี 1988 NSF ก็ต้องการให้ออกแบบ NSFNET ใหม่เนื่องจากมีผู้ใช้งานมากขึ้น และ 56 Kbps leased line ไม่สามารถรองรับงานได้ดีพอ ผู้ที่รับหน้าที่ออกแบบก็คือ MERIT Inc. ซึ่งเป็นการรวมตัวของมหาวิทยาลัย 8 แห่งในรัฐ Michigan บริษัท IBM Inc. และ MCI Inc. ผลที่ได้ก็คือ NSFNET มีจุดเชื่อมต่อเพิ่มเป็น 13 จุดเพื่อเป็น backup ของกันและกัน สามารถเปลี่ยนเส้นทางได้หากว่า link ใดเกิดมีปัญหาขึ้น มีความน่าเชื่อถือ (reliability) มากขึ้น ส่วน 1-level link ก็เปลี่ยนจาก 56 Kbps leased line เป็น T1 (1.544 Mbps) เร็วขึ้นมาอีกเยอะ ในภายหลังมีมหาวิทยาลัยจำนวนมากที่เชื่อมเข้ากับ NSFNET ก็เลยทำให้ NSFNET กลายเป็น backbone ของอินเทอร์เน็ตไปในที่สุด

NSFNET มีการเปลี่ยนแปลงอย่างต่อเนื่องเพื่อให้รองรับปริมาณข้อมูลที่สูงขึ้นทุกๆ ปี การใช้งานเครือข่ายก็เริ่มเปลี่ยนรูปแบบจากเครือข่ายเพื่องานวิจัยและการ ศึกษากลายมาเป็นเชิงพาณิชย์มากขึ้นจนกระทั่งในปี 1995 NSFNET ก็ไม่ได้รับการสนับสนุนทางการเงินจากรัฐบาลสหรัฐอีกต่อไป ทำให้ยุคของเครือข่าย NSFNET สิ้นสุดลง

Backbone ในปัจจุบัน: The very-high-speed Network Backbone Service

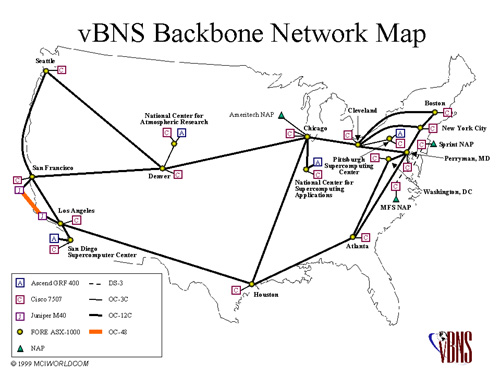

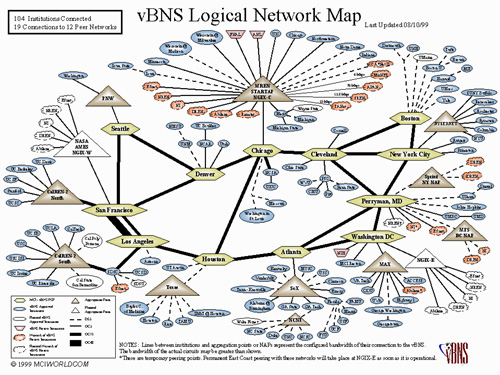

หลัง จากยกเลิก NSFNET ในปี 1995 backbone ของอินเทอร์เน็ตจึงเปลี่ยนจาก governmental-provided มาอยู่ในรูปของ commercial-provided คือให้เอกชนมาลงทุนแต่ NSF ยังคงให้การสนับสนุนและดูแลอยู่ เครือข่ายที่ว่านี่คือ vBNS – very-high-speed Backbone Network Service บริษัทที่ลงทุนก็คือ MCI Inc. หนึ่งใน MERIT Inc.นั่นเอง โดยเครือข่าย vBNS ก็ยังคงใช้เชื่อมต่อ supercomputer sites และ university sites ทั่วสหรัฐเหมือนเดิม แต่ปรับให้มีความเร็วสูงขึ้นและมีความน่าเชื่อถือมากขึ้น โครงสร้างหลักของ vBNS เป็นการเชื่อมต่อ supercomputer sites 5 แห่งและ network access point (NAP) อีก 4 จุด

เครือข่าย vBNS เริ่มต้นใช้ ATM ที่ OC-3 (155 Mbps …ฮู้ เร็วจัง) ผ่านโครงข่ายใยแก้วที่วางพาดจากฝั่งตะวันออกไปถึงฝั่งตะวันตกของสหรัฐ ในปี 1997 vBNS ก็ upgrade เป็น OC-12 (622 Mbps) เพื่อรองรับการเชื่อมต่อความเร็วสูงของมหาวิทยาลัยและสถาบันวิจัยกว่าร้อย แห่ง ล่าสุดเมื่อเดือนมีนาคม 1999 vBNS ก็วางแผน upgrade อีกครั้งเป็น OC-48 (2.4 Gbps … WAN ความเร็ว 2.4 Gbps เร็วกว่า link ดาวเทียมที่เราใช้แค่ 4000 เท่าเอง …-_-‘) ซึ่งคาดว่าจะเสร็จสมบูรณ์ภายในปี 1999 นี้

เครือข่าย vBNS ประกอบด้วย node ที่เป็น ATM switch 13 ตัวที่ทำงานที่ OC-3 rate โดยที่แต่ละจุดจะ config. permanent virtual path ไปยังจุดอื่นๆ ที่เหลือทั้งหมด (permanent virtual path เป็นเส้นทางที่กำหนดข้อมูลไหลผ่าน ATM switch ทำให้ protocol ในระดับที่สูงกว่า ATM เห็นเป็น end-to-end link แทนที่จะเป็น link ที่ผ่าน ATM switch หลายๆ ตัว) กลายเป็น full-mesh connection ซึ่งทำให้ router ในระดับ TCP/IP มองเห็น router ที่จุดอื่นห่างไปเพียงแค่ 1 hop เท่านั้น พูดอีกอย่างก็คือ router ใน vBNS จะเห็น router ที่จุดอื่นๆ เชื่อมต่อกับมันโดยตรง แม้ว่า physical connection จริงๆ จะต้องผ่าน ATM switch กี่ตัวก็ตาม ความเร็วของ ATM บน fiber optic ทำให้มี propagation delay (เวลาที่ข้อมูลใช้วิ่งอยู่ภายในสายสัญญาณ) ต่ำมากๆ ผลลัพธ์การ ping ใช้เวลาต่ำกว่า 100 ms ไม่ว่าจะ ping จากจุดใดใน vBNS .. นอกจากนี้อัตราการส่งข้อมูลที่สูงถึง 622 Mbps ทำให้ส่งข้อมูลจำนวนมากๆ ได้อย่างรวดเร็ว

vBNS ยังมี node ที่เป็น true-IPv6 และ MBone (Multimedia Backbone) ด้วย…เมื่อไหร่เมืองไทยจะมีมั่งน้าาา สงสัยต้องรอ ความหวังใหม่ ชาติไทย แล้วก็ชาติพัฒนารวมกันรึเปล่าเนี่ย (รวมกันก็ได้เป็น “หวังชาติใหม่ ชาติไทยพัฒนา” … -_-‘…เศร้า)

เครือข่ายระดับ International ISP

ปัจจุบัน vBNS ถือว่าเป็นเครือข่ายที่ให้บริการ wide-area interconnection ที่เร็วที่สุด การเชื่อมต่อยังมีรายละเอียดอื่นๆ อีกเยอะ อย่างเช่นเส้นทางที่เชื่อมไปยังประเทศอื่นๆ หรือทวีปอื่นๆ (ตอนนี้มีที่ผ่าน cable สาย Trans-Atlantic และ Trans-Pacific ความเร็วเป็น multiple ของ E1 – 2 Mbps บางส่วนก็เป็นดาวเทียม) นอกจากนี้ก็ยังมีเครือข่ายรองลงมาที่เป็นของ International Internet Service Provider อื่นๆ เช่น UUNet, Worldnet, Teleglobe, SprintNet หรืออื่นๆ เครือข่ายเหล่านี้ก็เช่าช่องสัญญาณของ vBNS นั่นแหละ อาจจะเรียกได้ว่าอยู่ระหว่าง 1-level กับ 2-level ก็พอได้

ขอ ยกตัวอย่าง UUNet นะ ปัจจุบัน UUNet เป็น ISP ที่ใหญ่ที่สุดในโลก เป็นบริษัทลูกของ MCI Inc. อีกที ก็แน่นอนว่าใช้ vBNS ด้วยเหมือนกัน UUNet มีเครือข่ายทั่วสหรัฐโดยใช้ช่องสัญญาณของ vBNS ให้บริการ connection ตั้งแต่ 28.8Kbps ถึง 155 Mbps และยังเชื่อมต่อไปยังทวีปยุโรป เอเชีย และ ออสเตรเลียด้วย รวมๆ แล้ว UUNet บริการ Internet ถึง 114 ประเทศ

ที่ ยกตัวอย่าง UUNet ก็เพราะได้ยินข่าวว่า UUNet จะมาตั้ง ISP ในเมืองไทย และดูเหมือนจะผ่านเงื่อนไขตามกฏหมายแล้วด้วย ผลที่ได้คือค่า ISP จะลดลงมาเยอะ (ประมาณว่าราคาขายส่งเพราะผู้ประกอบการมาเอง) ซึ่งเป็นผลดีกับผู้ใช้ที่จะจ่ายค่า ISP น้อยลง ทีนี้ ISP เมืองไทยก็ลำบากล่ะเพราะผู้ใช้มีทางเลือกที่ถูกกว่า และอาจจะดีกว่าด้วย ใครคิดจะกีดกันทางการค้าก็คงทำไม่ได้มากเพราะการเปิดเสรีโทรคมนาคมเป็นพันธ สัญญาที่ทำกับองค์การค้าโลก (WTO) อนาคตถ้า UUNet เริ่มกิจการและให้บริการในราคาถูกจริง ISP เมืองไทยอาจจะต้องรวมกลุ่มกันเพื่อลดต้นทุนการเช่าช่องสัญญาณ และแข่งขันการให้บริการที่มีประสิทธิภาพดีขึ้น .. ไม่ใช่ซื้อ package 20 ชั่วโมงใช้ได้ 7-8 ชั่วโมง ที่เหลือเป็นเวลาสายหลุดเหมือนทุกวันนี้ ..เศร้า

ข้อมูลที่วิ่งอยู่บน Backbone และลักษณะของ Internet trafficเอาล่ะ ที่นี้มาดูสถิติและการวิเคราะห์ traffic กันว่าเราใช้อะไรกันบ้างในอินเทอร์เน็ต .. มีงานวิจัยและการเก็บสถิติหลายงานที่แสดงถึงลักษณะของข้อมูลใน backbone ซึ่งสะท้อนถึงการเปลี่ยนแปลงของการใช้ข้อมูลบน Internet เราลองมาดูตั้งแต่ปี 1990 กันเลย

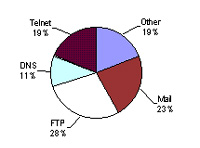

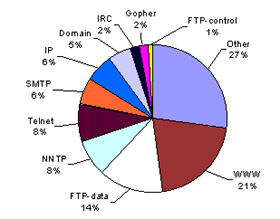

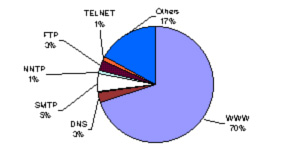

ข้อมูล ส่วนมากจะเป็น FTP mail และ telnet เป็นหลัก ในขณะที่ในปี 1995 ยุคของ World Wide Web ข้อมูลของ WWW ก็จะมีสัดส่วนสูงขึ้นมามาก หลังจากเปลี่ยนเป็น vBNS ยิ่งเห็นได้ชัดเพราะ 70% ของ packets ใน backbone เป็น packet ที่ติดต่อ web ในขณะที่ FTP เหลือแค่ 3% นักวิจัยหลายคนมองว่าในอนาคตหลังจากยุคของ WWW ข้อมูลส่วนมากจะเป็น multimedia และอาจจะมีสัดส่วนของ Internet multiplayer games และ Virtual Reality ด้วย จะจริงรึเปล่าก็ต้องรอดูกัน

งานวิจัยเรื่อง traffic บน Internet ส่วนมากจะเป็นการวัดค่าเพื่อหา characteristic ของอินเทอร์เน็ต …อันที่จริงการวิจัยประเภทนี้มีมานานแล้วแต่จนถึงปัจจุบันก็ยังหาข้อสรุป เกี่ยวกับ characteristic ไม่ได้เหตุผลนึงก็คือ อินเทอร์เน็ตมีการเปลี่ยนแปลงตลอดเวลา ทั้งจำนวนการใช้ สัดส่วนข้อมูล และลักษณะทางกายภาพ นักวิจัยเลยใช้คำว่า Internet Dynamic (ได้ยินชื่อน้องไดฯ หลายคนสะดุ้งเฮือก..สอบผ่านกันหรือยัง..ฮิๆๆๆ) สิ่งที่น่าสนใจคือลักษณะของ traffic ใน Internet ยังไม่สามารถหา model ทางสถิติใดๆ มาแทนได้ .. ทำให้ทุกวันนี้ยังไม่สามารถจำลองการทำงานของ Internet ได้อย่างถูกต้องจริงๆ เมื่อจำลองการทำงานไม่ได้ก็ทำให้วางแผน-ออกแบบ-และพยากรณ์ความเป็นไปของ เครือข่ายได้ยาก

ทุกวันนี้ถึงทำได้เพียงแค่เพิ่ม bandwidth – ลด delay ซึ่งเป็นการแก้ที่ปลายเหตุ งานวิจัยจำนวนมากวัดลักษณะการกระจายของช่วงเวลาระหว่าง packet (interarrival time between two packets) และพบว่ามันไม่มีการกระจายเป็น Exponential distribution ทำให้ไม่สามารถใช้ model ของ Poisson (Markovian model)เหมือนกับระบบที่เป็น network of queue ทั่วๆ ไป แม้แต่ traffic ที่ขึ้นกับการตัดสินใจของมนุษย์อย่าง Telnet หรือ FTP ซึ่งควรจะมีการกระจายใกล้เคียงกับ Exponential distribution ก็ไม่ผ่าน goodness-of-fit test ได้เลย ทั้งที่โดยธรรมชาติแล้ว Interarrival ที่เกิดจากมนุษย์จะมีการกระจายเป็น exponential distribution (อย่างเช่น ช่วงเวลาของคนสองคนที่เข้าไปกดตังค์ที่ตู้ ATM หรือซื้อข้าวเที่ยงกินที่ Cafe’) สาเหตุที่ไม่เป็น Exponential distribution อาจจะเป็นเพราะการติดต่อโดย Telnet/FTP ไม่ได้มี traffic ที่สร้างโดยมนุษย์เพียงอย่างเดียว แต่มีส่วนผสมของ traffic ที่สร้างจากเครื่องด้วย (เช่น ผลลัพธ์ที่หน้าจอ, file transfer) traffic พวกนี้ในภายหลังพบว่ามีการกระจายแบบเป็น Pareto distribution (ซึ่งเป็น double exponential – กราฟเป็น exponential ใน log scale) งานวิจัยช่วงหลังจึงเปลี่ยนมาเป็นการหา characteristic โดยใช้วิธีอื่นแทนที่ไม่ใช่ exponential, poisson หรือการกระจายทางสถิติทั่วๆ ไป ปัจจุบันนักวิจัยหันไปใช้ self-similarity model (fractal) แทน ..คนที่เคยได้ยินหรือรู้จัก fractal คงจะงงว่าเกี่ยวอะไรด้วยเนี่ย ?

ส่วนใหญ่เราจะเข้าใจว่า fractal เป็นสมการสำหรับ computer graphics เท่านั้น (ผมก็เป็นหนึ่งในนั้น) อย่างรูป ของสมการ mandelbrot, julia, หรือ fern ซึ่งเป็นรูป fractal ยอดฮิต อันที่จริง fractal เป็น model ที่สามารถเอาใปใช้ในสาขาอื่นๆ ได้อีกมากเพื่อใช้วิเคราะห์ในเชิงสถิติ เช่นในสาขา hydrology ใช้พยากรณ์การเกิดน้ำท่วม พยากรณ์ปริมาณน้ำและฝนเพื่อหาพืชที่ควรจะเพาะปลูกในแต่ละปี หรือ data compression ตอนนี้ก็เอาสมการ fractal มาใช้ลดขนาดข้อมูลกัน ส่วนสาขา telecommunication ก็เอาไว้ใช้พยากรณ์ traffic ภายในเครือข่ายเพื่อจะได้ปรับเปลี่ยน configuration ให้เหมาะสม

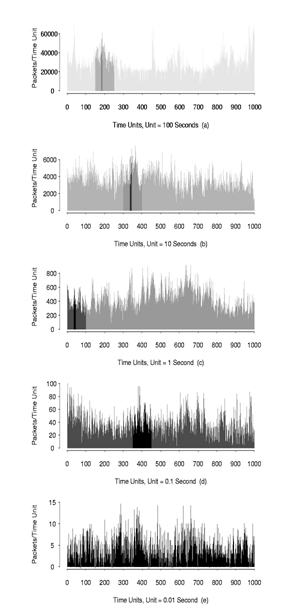

Self-similarity หรือ Fractal เป็นทฤษฎีที่คิดโดย B. B. Mandelbrot มา 30 กว่าปีเห็นจะได้ แล้วก็ไม่ได้เอาไว้วาดรูปอย่างเดียวอย่างที่หลายคนเข้าใจกัน แต่ fractal สามารถอธิบายในเชิง computer graphics ได้ง่ายหน่อยและเห็นภาพชัดเจนว่าคืออะไร คนส่วนมากจึงรู้จัก fractal ใน computer graphics ถ้าอธิบายสั้นๆ fractal หรือ self-similarity หมายความว่าสิ่งที่ปรากฏจะมีความ “คล้าย” กันไม่ว่าจะดูด้วยความละเอียดเท่าใด ถ้าเป็นรูปก็หมายความว่า เราสามารถ zoom เข้า-ออกได้โดยผลลัพธ์ที่ได้จะมีลักษณะคล้ายภาพเดิม หรือถ้าพูดกลับกันก็คือไม่ว่าจะ zoom ไปกี่เท่าความละเอียดของภาพก็จะยังเหมือนเดิมและมีลักษณะคล้ายกับของ เดิม..เป็นที่มาของคำว่า self-similarity ไง ทีนี้สิ่งที่นักวิจัยพบก็คือลักษณะของ traffic ใน Ethernet LAN มีลักษณะคล้ายกันไม่ว่าจะวัดด้วยความละเอียดเท่าไหร่ก็ตาม พูดอีกอย่างก็คือไม่ว่าจะใช้ scale เวลาที่ละเอียดขนาด 0.01s, 0.1s, 1s, 10 s, หรือ 100 s ลักษณะของ traffic ที่วัดได้ก็มีหน้าตาคล้ายๆ กัน (ดูรูปทางขวามือ) เมื่อทดสอบโดยวิธีทางสถิติก็พบว่ามันมีคุณสมบัติ self-similar จริง หลังจากมีคนพบว่า Ethernet traffic มีลักษณะเป็น self-similar แล้วจึงมี idea ว่า traffic ของอินเทอร์เน็ตก็อาจจะเป็น self-similar เหมือนกันเพราะ traffic ส่วนนึงใน Internet เป็นการรวมกันของ Ethernet traffic หลายๆ อันเข้าด้วยกัน ก็ต้องรอดูกันต่อไปว่าจะสำเร็จหรือเปล่า การวัดหาค่าลักษณะนี้ไม่ใช่ง่ายๆ ต้องวัดละเอียดมากและต้องไม่ให้การวัดมีผลกระทบต่อ traffic ด้วย ข้อมูลก็ต้องสะสมเป็นเวลานานเป็นปีๆ ซึ่งทำให้ได้รับผลกระทบจาก Internet dynamic อย่างแน่นอน ก็ต้องหาทางแก้ใขหรือปรับข้อมูลที่เก็บมาได้นอกจากนี้การเก็บข้อมูลยังเป็น สิ่งที่ละเอียดอ่อนและมีผลกระทบต่อ user privacy อีก (อเมริกามีกฏหมายห้าม ISP เข้าถึงข้อมูลของผู้ใช้บนเครือข่าย) ที่ผ่านมาจึงวัดค่าได้เฉพาะภายใน local network (ซึ่งไม่กว้างพอ) หรือเก็บ statistic data จากอุปกรณ์เครือข่าย (ซึ่งไม่ละเอียดพอ) หรือใช้โปรแกรมพิเศษสุ่มทดสอบเป็นช่วงๆ เท่านั้น (ซึ่งไม่ใช่ค่าที่แท้จริง) แต่หากทำได้จริงและสามารถหา characteristic ของอินเทอร์เน็ต ได้ เราก็จะสามารถเข้าใจพฤติกรรมของ Internet ทราบถึงผลกระทบต่างๆ เมื่อมีการเปลี่ยนแปลงภายในอินเทอร์เน็ตผลลัพธ์คือเราสามารถควบคุม traffic บน อินเทอร์เน็ตได้ สามารถวางแผนรับปริมาณข้อมูลที่สูงขึ้นและการเปลี่ยนพฤติกรรมของผู้ใช้ใน อนาคต และทำให้เราได้ใช้ทรัพยากรได้เต็มประสิทธิภาพอย่างแท้จริง